Introdução: O cenário em evolução da PNL

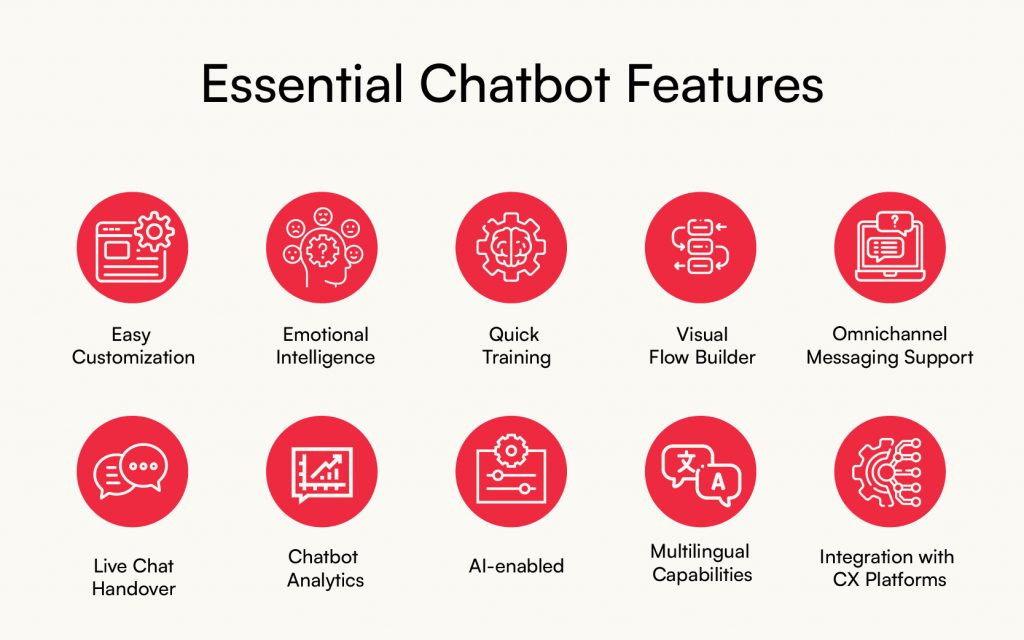

A aceleração do desenvolvimento de modelos de linguagem, aliada à democratização das ferramentas de IA, criou um ecossistema onde os desenvolvedores podem implementar recursos complexos de compreensão de linguagem com uma facilidade sem precedentes. Seja para criar chatbots de atendimento ao cliente, plataformas de análise de conteúdo ou aplicativos habilitados para voz, a biblioteca de PNL certa pode reduzir drasticamente o tempo de desenvolvimento e, ao mesmo tempo, aprimorar a inteligência de suas soluções.

Neste guia abrangente, exploraremos as sete bibliotecas de PNL mais poderosas e versáteis disponíveis para desenvolvedores em 2025. Analisaremos seus pontos fortes, limitações e casos de uso ideais para ajudá-lo a tomar decisões informadas para seu próximo projeto focado em linguagem.

Transformadores de rostos abraçados: a potência movida pela comunidade

A versão 5.0 mais recente introduziu otimizações significativas no uso de memória e na velocidade de inferência, abordando limitações anteriores ao implantar modelos maiores em ambientes de produção. Seu novo pipeline "Inferência Eficiente" tornou a execução de modelos sofisticados em dispositivos de ponta mais viável do que nunca.

O que realmente diferencia o Hugging Face é sua comunidade vibrante. Com mais de 150.000 modelos pré-treinados disponíveis em seu hub, os desenvolvedores podem encontrar soluções para praticamente qualquer tarefa de linguagem imaginável. A integração perfeita com frameworks populares como PyTorch e TensorFlow oferece flexibilidade sem sacrificar o desempenho.

O recurso AutoNLP amadureceu consideravelmente, permitindo que desenvolvedores com experiência limitada em ML ajustem modelos personalizados com código mínimo. Essa democratização de recursos avançados de PNL fez do Hugging Face a base de muitas aplicações centradas em linguagem.

Ideal para: Equipes que precisam de acesso rápido a modelos de última geração, projetos que exigem tarefas de linguagem altamente especializadas e desenvolvedores que valorizam o suporte e a documentação da comunidade.

spaCy 4.0: Eficiência e PNL de nível de produção

O design orientado a objetos da biblioteca a torna excepcionalmente intuitiva para desenvolvedores Python, com uma API limpa que lida com tudo, desde a tokenização até o reconhecimento de entidades nomeadas. A introdução do sistema "Transformer Components" agora permite que os desenvolvedores incorporem facilmente modelos baseados em transformadores ao pipeline tradicional do spaCy, equilibrando a eficiência com o poder das arquiteturas mais recentes.

Uma das vantagens mais significativas do spaCy é sua abordagem criteriosa ao desempenho. A funcionalidade principal é implementada em Cython, resultando em velocidades de processamento que frequentemente superam os concorrentes em ordens de magnitude ao lidar com grandes corpora de texto. Essa eficiência o torna particularmente valioso para pipelines de ingestão de dados e aplicações em tempo real.

O ecossistema em torno do spaCy cresceu substancialmente, com pacotes especializados para processamento de textos nas áreas de saúde, jurídica e financeira, agora disponíveis como extensões plug-and-play. Esse suporte específico a domínios o tornou cada vez mais popular em ambientes corporativos onde a precisão em contextos especializados é fundamental.

Ideal para: Sistemas de produção que exigem eficiência e confiabilidade, pipelines de processamento de dados que lidam com grandes volumes de texto e projetos onde a integração com bases de código Python existentes é prioritária.

Google JAX-NLP: A Fronteira do Desempenho

O que distingue o JAX-NLP é sua abordagem baseada em compilador, que otimiza as cargas de trabalho de NLP para configurações de hardware específicas. Isso se traduz em tempos de treinamento significativamente mais rápidos e inferência mais eficiente, particularmente na arquitetura TPU do Google. Para equipes que trabalham com conjuntos de dados massivos ou que exigem processamento em tempo real de tarefas complexas de linguagem, esses benefícios de desempenho podem ser transformadores.

A biblioteca introduz a "programação diferencial" ao NLP, permitindo a diferenciação e transformação automáticas de funções numéricas. Em termos práticos, isso significa que os desenvolvedores podem experimentar novas arquiteturas de modelos com mais flexibilidade, potencialmente descobrindo abordagens mais eficientes para casos de uso específicos.

No entanto, o JAX-NLP apresenta uma curva de aprendizado mais acentuada do que algumas alternativas. O paradigma de programação funcional que ele emprega pode parecer desconhecido para desenvolvedores acostumados a frameworks mais imperativos. Além disso, embora a documentação tenha melhorado significativamente, ela ainda carece dos amplos recursos gerados pela comunidade que as bibliotecas mais consolidadas desfrutam.

Ideal para: Equipes de pesquisa que ultrapassam os limites de desempenho, aplicações que exigem máxima eficiência computacional e projetos com acesso a aceleradores de hardware especializados.

PyTorch-NLP: Pipeline flexível de pesquisa para produção

O ecossistema amadureceu significativamente, com suporte abrangente para pré-processamento de dados, implementação de modelos e métricas de avaliação. O componente TextWrangler, introduzido no final de 2024, simplificou um dos aspectos mais tediosos do desenvolvimento de NLP — limpeza e preparação de dados — com automação inteligente que se adapta a diferentes fontes de texto.

Para desenvolvedores que trabalham na interseção entre visão computacional e processamento de linguagem (como em aplicações multimodais), o PyTorch-NLP oferece integração perfeita com o ecossistema PyTorch mais amplo. Essa interoperabilidade o tornou particularmente valioso, visto que as aplicações combinam cada vez mais múltiplas formas de análise de dados.

Os recursos do TorchScript permitem a fácil implantação de modelos em diferentes ambientes, abordando preocupações anteriores sobre o pipeline da pesquisa à produção. Os modelos desenvolvidos em PyTorch-NLP agora podem ser exportados para ambientes de produção com o mínimo de atrito, preservando o desempenho e adaptando-se às restrições de implantação.

Ideal para: Equipes voltadas para pesquisa que precisam eventualmente implantar em produção, desenvolvedores trabalhando em aplicações multimodais e projetos que exigem arquiteturas de modelos personalizadas.

NLTK Modernizado: O Pilar Educacional Evolui

A versão mais recente mantém os pontos fortes pedagógicos do NLTK, incorporando adaptadores para modelos modernos baseados em transformadores. Essa abordagem híbrida preserva o valor educacional excepcional da biblioteca, permitindo que os desenvolvedores utilizem técnicas contemporâneas quando necessário.

O NLTK continua a se destacar em tarefas tradicionais de PNL, como tokenização, stemming e análise sintática. Seu conjunto abrangente de algoritmos clássicos o torna particularmente valioso para aplicações focadas em linguística e para desenvolvedores que precisam entender os fundamentos antes de implementar soluções de aprendizado profundo de caixa preta.

A integração com ferramentas de IA explicáveis é outro avanço notável. O NLTK agora inclui recursos integrados de visualização e explicação que ajudam os desenvolvedores a entender por que os modelos fazem previsões específicas — um recurso crucial para aplicações em setores regulamentados onde a interpretabilidade é obrigatória.

Melhor para: Contextos educacionais, aplicações focadas em linguística que exigem técnicas tradicionais de PNL e projetos onde a transparência e a explicabilidade do algoritmo são essenciais.

TensorFlow Text 3.0: Processamento de Linguagem de Nível Empresarial

A biblioteca se destaca na otimização de desempenho em diversos ambientes de hardware. Com suporte de primeira classe para quantização e poda, o TensorFlow Text permite que os desenvolvedores implantem modelos de linguagem sofisticados em ambientes com recursos limitados sem sacrificar funcionalidades essenciais.

A integração com o TensorFlow Extended (TFX) fornece pipelines robustos para validação de dados, treinamento de modelos e implantação, abordando o ciclo de vida de aprendizado de máquina de ponta a ponta. Essa abordagem abrangente é particularmente valiosa para organizações que implementam PLN em escala, onde a reprodutibilidade e a governança são tão importantes quanto o desempenho bruto.

O suporte integrado da biblioteca para processamento multilíngue expandiu significativamente, com componentes especializados para mais de 100 idiomas. Essa diversidade a torna uma excelente escolha para aplicações globais que exigem desempenho consistente em diferentes contextos linguísticos.

Melhor para: implantações corporativas que exigem integração robusta de MLOps, aplicativos que precisam ser implantados em diversos ambientes de hardware e projetos multilíngues que abrangem vários idiomas.

Rust-NLP: A Nova Fronteira de Desempenho

O que torna o Rust-NLP particularmente interessante é seu foco na segurança da memória sem sacrificar o desempenho. Isso o torna especialmente valioso para aplicações onde as considerações de segurança são primordiais, como o processamento de informações de identificação pessoal ou a implementação de recursos de linguagem em sistemas críticos em termos de segurança.

A biblioteca fornece implementações nativas dos principais algoritmos de PNL em vez de simplesmente encapsular bibliotecas existentes, resultando em melhorias de desempenho de até 300% para determinadas operações em comparação com alternativas baseadas em Python. Essa eficiência se traduz em menores custos de infraestrutura e melhores tempos de resposta.

Embora o ecossistema ainda esteja em desenvolvimento, a interoperabilidade com Python por meio de vinculações PyO3 permite que os desenvolvedores adotem gradualmente o Rust-NLP para componentes críticos em termos de desempenho, mantendo os fluxos de trabalho existentes baseados em Python para outros aspectos de suas aplicações.

Melhor para: Aplicativos de desempenho crítico, processamento de linguagem sensível à segurança e equipes dispostas a investir em tecnologias mais recentes para ganhos significativos de eficiência.

Comparação: Escolhendo a ferramenta certa para seu projeto

Para Prototipagem e Experimentação Rápidas:

O Hugging Face Transformers oferece acesso incomparável a modelos pré-treinados

O PyTorch-NLP oferece flexibilidade para arquiteturas personalizadas

O NLTK Modernized oferece valor educacional juntamente com utilidade prática

Para Implantação em Produção em Escala:

O SpaCy 4.0 equilibra o desempenho com a experiência do desenvolvedor

O TensorFlow Text 3.0 se destaca em ambientes corporativos

O Rust-NLP oferece desempenho incomparável para componentes críticos

Para Aplicações Especializadas:

O Google JAX-NLP permite otimização de desempenho de ponta

O NLTK oferece explicabilidade superior para setores regulamentados

As extensões específicas de domínio do SpaCy atendem aos requisitos verticais específicos

Considere não apenas suas necessidades atuais, mas também sua trajetória de crescimento prevista. Os recursos de integração, o suporte da comunidade e as perspectivas de manutenção de longo prazo devem ser levados em consideração na sua decisão, juntamente com os recursos técnicos puros.

Conclusão: O Futuro do Desenvolvimento da PNL

A tendência de especialização provavelmente continuará, com as bibliotecas se concentrando cada vez mais em domínios ou características de desempenho específicos, em vez de tentarem ser soluções universais. Essa especialização beneficia os desenvolvedores, pois fornece ferramentas mais personalizadas para problemas específicos.

Simultaneamente, estamos observando uma maior interoperabilidade entre diferentes bibliotecas e frameworks, reconhecendo que a maioria das aplicações do mundo real utilizará múltiplas abordagens, dependendo de requisitos específicos. Essa evolução pragmática reflete o amadurecimento do ecossistema da PNL.

Para desenvolvedores que estão entrando na área ou expandindo suas capacidades de processamento de linguagem, compreender as características distintivas dessas bibliotecas é essencial para tomar decisões arquitetônicas informadas. Ao selecionar as ferramentas certas para suas necessidades específicas, você pode aproveitar o notável poder da PNL moderna, ao mesmo tempo em que gerencia a complexidade inerente à compreensão da linguagem.

Ao embarcar em seu próximo projeto de PNL, lembre-se de que a melhor biblioteca é, em última análise, aquela que se alinha à expertise da sua equipe, aos requisitos do seu projeto e às necessidades dos seus usuários. Com as opções poderosas disponíveis em 2025, você estará bem equipado para criar aplicativos com reconhecimento de linguagem que seriam impensáveis há apenas alguns anos.