Como os chatbots modernos realmente funcionam

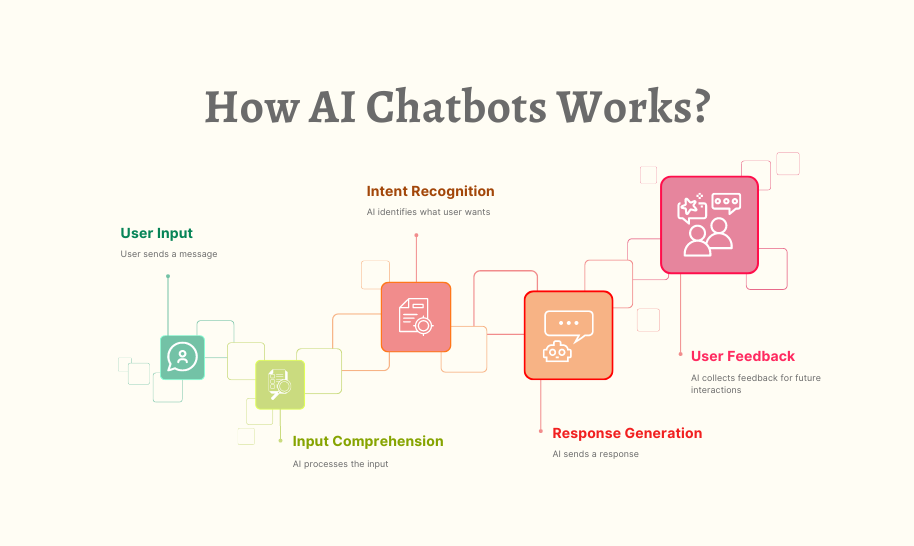

A aparente simplicidade dos chatbots modernos mascara uma orquestra tecnológica incrivelmente sofisticada tocando nos bastidores. O que parece uma simples troca de texto envolve vários sistemas de IA especializados trabalhando em conjunto: processando sua linguagem, recuperando informações relevantes, gerando respostas apropriadas e aprendendo constantemente com as interações.

Como alguém que passou anos desenvolvendo e implementando sistemas de chatbot para diversos setores, tive um lugar privilegiado para sua notável evolução. Muitos usuários se surpreendem ao saber que os chatbots modernos não são programas de IA isolados, mas sim ecossistemas complexos de componentes especializados trabalhando em conjunto. Compreender esses componentes não apenas desmistifica o que às vezes pode parecer mágica tecnológica, mas também nos ajuda a compreender melhor suas capacidades e limitações.

Nesta exploração, vamos desvendar os chatbots modernos para entender as principais tecnologias que os impulsionam, como esses sistemas são treinados e como eles superam os desafios fundamentais da linguagem humana. Se você está pensando em implementar um chatbot para sua empresa ou simplesmente tem curiosidade sobre a tecnologia com a qual interage diariamente, este tour pelos bastidores fornecerá insights valiosos sobre uma das aplicações mais visíveis da IA.

A Fundação: Grandes Modelos de Linguagem

A escala desses modelos é difícil de compreender. Os maiores LLMs têm centenas de bilhões de parâmetros – os valores ajustáveis que o modelo usa para fazer previsões. Durante o treinamento, esses parâmetros são gradualmente refinados à medida que o modelo processa enormes conjuntos de dados compostos por livros, artigos, sites, repositórios de código e outros textos – muitas vezes totalizando trilhões de palavras.

Por meio desse processo de treinamento, os modelos de linguagem desenvolvem uma compreensão estatística de como a linguagem funciona. Eles aprendem vocabulário, gramática, fatos sobre o mundo, padrões de raciocínio e até mesmo algum grau de senso comum. É importante ressaltar que eles não simplesmente memorizam seus dados de treinamento – eles aprendem padrões generalizáveis que lhes permitem lidar com novas entradas que nunca viram antes.

Ao enviar uma mensagem para um chatbot alimentado por um LLM, seu texto é primeiro convertido em representações numéricas chamadas tokens. O modelo processa esses tokens por meio de suas diversas camadas de conexões neurais, produzindo, por fim, distribuições de probabilidade para quais tokens devem vir em seguida em uma resposta. O sistema então converte esses tokens novamente em texto legível por humanos.

Os modelos de linguagem mais avançados atualmente incluem:

GPT-4: O modelo da OpenAI impulsiona o ChatGPT e muitos outros aplicativos comerciais, conhecido por suas fortes capacidades de raciocínio e amplo conhecimento.

Claude: A família de modelos da Anthropic, projetada com ênfase em utilidade, inocuidade e honestidade.

Llama 3: Os modelos de peso aberto da Meta, que democratizaram o acesso à poderosa tecnologia LLM.

Gemini: Os modelos multimodais do Google que podem processar texto e imagens.

Mistral: Uma família de modelos eficientes que oferecem desempenho impressionante, apesar da menor contagem de parâmetros.

Apesar de suas capacidades notáveis, os modelos de linguagem base, por si só, apresentam limitações significativas como agentes conversacionais. Eles não têm acesso a informações em tempo real, não conseguem pesquisar na internet ou em bancos de dados para verificar fatos e, frequentemente, "alucinam" – gerando informações aparentemente plausíveis, mas incorretas. Além disso, sem personalização adicional, eles não têm conhecimento de negócios, produtos ou contextos de usuários específicos.

É por isso que as arquiteturas modernas de chatbots integram LLMs com vários outros componentes cruciais para criar sistemas conversacionais verdadeiramente úteis.

Geração Aumentada por Recuperação: Fundamentando Chatbots em Fatos

Os sistemas RAG funcionam combinando as capacidades generativas dos modelos de linguagem com a precisão dos sistemas de recuperação de informações. Veja como um processo RAG típico flui em um chatbot moderno:

Processamento de Consultas: Quando um usuário faz uma pergunta, o sistema a analisa para identificar as principais necessidades de informação.

Recuperação de Informações: Em vez de depender apenas dos dados de treinamento do LLM, o sistema pesquisa em bases de conhecimento relevantes – que podem incluir documentação da empresa, catálogos de produtos, perguntas frequentes ou até mesmo o conteúdo ativo de um website.

Seleção de Documentos Relevantes: O sistema de recuperação identifica os documentos ou trechos mais relevantes com base na similaridade semântica com a consulta.

Aumento de Contexto: Esses documentos recuperados são fornecidos ao modelo de linguagem como contexto adicional ao gerar sua resposta.

Geração de Respostas: O LLM produz uma resposta que incorpora tanto seus recursos de linguagem geral quanto as informações específicas recuperadas.

Atribuição da Fonte: Muitos sistemas RAG também rastreiam quais fontes contribuíram para a resposta, permitindo citação ou verificação.

Essa abordagem combina o melhor dos dois mundos: a capacidade do LLM de compreender perguntas e gerar linguagem natural, com a precisão e a atualização das informações dos sistemas de recuperação. O resultado é um chatbot que pode fornecer informações específicas e factuais sobre produtos, políticas ou serviços sem recorrer a alucinações.

Considere um chatbot de atendimento ao cliente de um e-commerce. Quando questionado sobre as políticas de devolução de um produto específico, um LLM puro pode gerar uma resposta plausível, mas potencialmente incorreta, com base nos padrões gerais observados durante o treinamento. Um chatbot aprimorado pelo RAG, em vez disso, recuperaria o documento da política de devolução da empresa, encontraria a seção relevante sobre aquela categoria de produto e geraria uma resposta que refletisse com precisão a política atual.

A sofisticação dos sistemas RAG continua a avançar. Implementações modernas utilizam embeddings de vetores densos para representar consultas e documentos em um espaço semântico de alta dimensão, permitindo a recuperação com base no significado, em vez de apenas na correspondência de palavras-chave. Alguns sistemas empregam pipelines de recuperação em vários estágios, primeiro lançando uma rede ampla e, em seguida, refinando os resultados por meio de reclassificação. Outros determinam dinamicamente quando a recuperação é necessária e quando o LLM pode responder com segurança a partir de seu conhecimento paramétrico.

Para empresas que implementam chatbots, a implementação eficaz do RAG requer uma preparação cuidadosa da base de conhecimento – organizando as informações em blocos recuperáveis, atualizando o conteúdo regularmente e estruturando os dados de forma a facilitar a recuperação precisa. Quando implementado corretamente, o RAG melhora drasticamente a precisão do chatbot, especialmente para aplicações específicas de domínio, onde a precisão é crucial.

Gerenciamento de Estado Conversacional: Mantendo o Contexto

Os chatbots modernos empregam sistemas sofisticados de gerenciamento de estado conversacional para manter trocas coerentes e contextuais. Esses sistemas rastreiam não apenas o conteúdo explícito das mensagens, mas também o contexto implícito que os humanos naturalmente mantêm durante as conversas.

A forma mais básica de gerenciamento de estado é o rastreamento do histórico de conversas. O sistema mantém um buffer de trocas recentes (tanto entradas do usuário quanto suas próprias respostas) que é fornecido ao modelo de linguagem a cada nova consulta. No entanto, à medida que as conversas se tornam mais longas, incluir todo o histórico torna-se impraticável devido às limitações de comprimento de contexto, mesmo dos LLMs mais avançados.

Para lidar com essa restrição, chatbots sofisticados empregam diversas técnicas:

Sumarização: Condensar periodicamente partes anteriores da conversa em resumos concisos que capturam informações importantes e, ao mesmo tempo, reduzem o uso de tokens.

Rastreamento de entidades: Monitorar explicitamente entidades importantes (pessoas, produtos, problemas) mencionadas ao longo da conversa e mantê-las estruturadas.

Conscientização sobre o estágio da conversa: Rastrear em que ponto do fluxo do processo a conversa se encontra – seja coletando informações, propondo soluções ou confirmando ações.

Persistência do contexto do usuário: Manter informações relevantes do usuário em todas as sessões, como preferências, histórico de compras ou detalhes da conta (com controles de privacidade apropriados).

Memória de intenção: Lembrar do objetivo original do usuário, mesmo durante desvios e esclarecimentos na conversa.

Considere um cenário de atendimento ao cliente: Um usuário começa a perguntar sobre a atualização de seu plano de assinatura e, em seguida, faz várias perguntas detalhadas sobre recursos, comparações de preços e ciclos de cobrança, antes de finalmente decidir prosseguir com a atualização. Um sistema eficaz de gerenciamento de estado conversacional garante que, quando o usuário disser "Sim, vamos fazer isso", o chatbot entenda exatamente a que "isso" se refere (a atualização) e tenha retido todos os detalhes relevantes da conversa.

A implementação técnica do gerenciamento de estado varia de acordo com a plataforma. Alguns sistemas utilizam uma abordagem híbrida, combinando o rastreamento simbólico de estados (modelando explicitamente entidades e intenções) com os recursos implícitos de grandes janelas de contexto em LLMs modernos. Outros empregam módulos de memória especializados que recuperam seletivamente partes relevantes do histórico de conversas com base na consulta atual.

Para aplicações complexas como atendimento ao cliente ou vendas, o gerenciamento de estados frequentemente se integra à modelagem de processos de negócios, permitindo que os chatbots guiem as conversas por meio de fluxos de trabalho definidos, mantendo a flexibilidade para uma interação natural. As implementações mais avançadas podem até mesmo rastrear o estado emocional juntamente com o contexto factual, ajustando o estilo de comunicação com base no sentimento do usuário detectado.

O gerenciamento de contexto eficaz transforma as interações do chatbot de trocas desconexas de perguntas e respostas em conversas genuínas que se baseiam no entendimento compartilhado – um fator crítico na satisfação do usuário e nas taxas de conclusão de tarefas.

Compreensão da Linguagem Natural: Interpretando a Intenção do Usuário

Os sistemas modernos de NLU em chatbots normalmente desempenham várias funções importantes:

Reconhecimento de Intenção: Identificar o objetivo ou propósito subjacente do usuário. O usuário está tentando fazer uma compra, relatar um problema, solicitar informações ou algo mais? Sistemas avançados podem reconhecer intenções múltiplas ou aninhadas em uma única mensagem.

Extração de Entidade: Identificar e categorizar informações específicas na mensagem do usuário. Por exemplo, em "Preciso transferir meu voo de Chicago para Boston na quinta-feira", as entidades incluem locais (Chicago, Boston) e horário (quinta-feira).

Análise de Sentimento: Detectar o tom e a atitude emocional, o que ajuda o chatbot a ajustar seu estilo de resposta adequadamente. O usuário está frustrado, animado, confuso ou neutro?

Identificação do Idioma: Determinar o idioma que o usuário está falando para fornecer respostas apropriadas em ambientes multilíngues.

Enquanto as plataformas de chatbot anteriores exigiam programação explícita de intenções e entidades, os sistemas modernos aproveitam os recursos inerentes de compreensão de linguagem dos LLMs. Isso permite que eles lidem com uma gama muito mais ampla de expressões sem exigir uma enumeração exaustiva de possíveis frases.

Quando um usuário digita "O processo de checkout continua travando na página de pagamento", um sistema NLU sofisticado identificaria isso como uma intenção de suporte técnico, extrairia "processo de checkout" e "página de pagamento" como entidades relevantes, detectaria frustração no sentimento e encaminharia essas informações para o caminho apropriado de geração de resposta.

A precisão do NLU impacta significativamente a satisfação do usuário. Quando um chatbot interpreta mal as solicitações de forma consistente, os usuários perdem rapidamente a confiança e a paciência. Para melhorar a precisão, muitos sistemas empregam pontuação de confiança – quando a confiança na compreensão cai abaixo de certos limites, o chatbot pode fazer perguntas esclarecedoras em vez de prosseguir com suposições potencialmente incorretas.

Para aplicações específicas de domínio, os sistemas NLU frequentemente incorporam terminologia especializada e reconhecimento de jargões. Um chatbot de saúde, por exemplo, seria treinado para reconhecer termos e sintomas médicos, enquanto um bot de serviços financeiros entenderia terminologia bancária e tipos de transação.

A integração da NLU com os outros componentes é crucial. As intenções e entidades extraídas informam os processos de recuperação, ajudam a manter o estado conversacional e orientam a geração de respostas – servindo como o elo crítico entre o que os usuários dizem e o que o sistema faz.

Geração e otimização de respostas

Em sistemas modernos, a geração de respostas normalmente envolve várias etapas:

Planejamento de Respostas: Determinar quais informações incluir, perguntas fazer ou ações sugerir com base no estado atual da conversa e no conhecimento disponível.

Seleção de Conteúdo: Escolher quais fatos, explicações ou opções específicas apresentar a partir de conjuntos potencialmente grandes de informações relevantes.

Estruturação: Organizar o conteúdo selecionado em uma sequência lógica e fácil de seguir que atenda às necessidades do usuário de forma eficaz.

Realização: Converter o conteúdo planejado em uma linguagem natural e fluente que corresponda ao tom e estilo desejados do chatbot.

Embora os LLMs possam gerar textos impressionantemente coerentes, a geração descontrolada frequentemente leva a problemas como verbosidade excessiva, inclusão de informações irrelevantes ou respostas que não se alinham aos objetivos do negócio. Para lidar com essas questões, sistemas sofisticados de chatbot implementam diversas técnicas de otimização:

Modelos de Resposta: Para cenários comuns com necessidades de informação previsíveis, muitos sistemas utilizam modelos parametrizados que garantem respostas consistentes e eficientes, permitindo a personalização.

Controle de Duração: Mecanismos para ajustar a duração da resposta com base na complexidade da consulta, na plataforma onde a interação ocorre e nas preferências do usuário.

Orientação de Tom e Estilo: Instruções que ajustam a formalidade, a simpatia ou o nível técnico das respostas com base no contexto da conversa e nas características do usuário.

Planejamento Multi-Turno: Para tópicos complexos, os sistemas podem planejar respostas em múltiplas etapas, dividindo intencionalmente as informações em blocos de fácil assimilação, em vez de sobrecarregar os usuários com blocos de texto.

Integração da Lógica de Negócios: Regras que garantem que as respostas estejam alinhadas com as políticas de negócios, requisitos regulatórios e recursos de serviço.

Os chatbots mais eficazes também empregam estratégias de resposta adaptáveis. Eles monitoram os sinais de engajamento e satisfação do usuário para refinar sua abordagem de comunicação ao longo do tempo. Se os usuários solicitarem esclarecimentos com frequência após um determinado tipo de resposta, o sistema poderá se ajustar automaticamente para fornecer explicações mais detalhadas em cenários futuros semelhantes.

Um aspecto crucial da geração de respostas é o gerenciamento da incerteza. Quando as informações não estão disponíveis ou são ambíguas, sistemas bem projetados reconhecem as limitações em vez de gerar respostas aparentemente confiáveis, mas potencialmente incorretas. Essa transparência gera confiança e gerencia as expectativas do usuário de forma eficaz.

Para aplicações de missão crítica, como saúde ou serviços financeiros, muitas implementações incluem mecanismos de revisão humana para determinados tipos de respostas antes que elas cheguem aos usuários. Essas proteções fornecem uma camada adicional de controle de qualidade para interações de alto risco.

Módulos Especializados para Ações e Integração

Esses recursos de ação são implementados por meio de módulos especializados que conectam a interface conversacional a sistemas externos:

Estrutura de Integração de API: Uma camada de middleware que traduz solicitações conversacionais em chamadas de API devidamente formatadas para diversos serviços de back-end – sistemas de pedidos, plataformas de CRM, processadores de pagamento, sistemas de reservas, etc.

Autenticação e Autorização: Componentes de segurança que verificam a identidade e os níveis de permissão do usuário antes de realizar ações confidenciais ou acessar informações protegidas.

Assistência ao Preenchimento de Formulários: Módulos que ajudam os usuários a preencher formulários complexos por meio de interação conversacional, coletando as informações necessárias aos poucos, em vez de apresentar formulários complexos.

Processamento de Transações: Componentes que lidam com processos de várias etapas, como compras, reservas ou alterações de conta, mantendo o estado durante todo o processo e tratando exceções com eficiência.

Sistemas de Notificação: Capacidades para enviar atualizações, confirmações ou alertas por meio de vários canais (e-mail, SMS, notificações no aplicativo) conforme as ações progridem ou são concluídas.

A sofisticação dessas integrações varia muito entre as implementações. Chatbots simples podem incluir a funcionalidade básica de "transferência" que transfere os usuários para agentes humanos ou sistemas especializados quando uma ação é necessária. Implementações mais avançadas oferecem experiências completas e integradas, nas quais o chatbot cuida de todo o processo dentro da conversa.

Considere um chatbot de uma companhia aérea ajudando um passageiro a alterar um voo. Ele precisa:

Autenticar o usuário e recuperar sua reserva

Pesquisar voos alternativos disponíveis

Calcular quaisquer diferenças de tarifa ou taxas de alteração

Processar o pagamento, se necessário

Emitir novos cartões de embarque

Atualizar a reserva em vários sistemas

Enviar detalhes de confirmação pelos canais preferenciais

Para isso, é necessária a integração com sistemas de reservas, processadores de pagamento, serviços de autenticação e plataformas de notificação – tudo orquestrado pelo chatbot, mantendo um fluxo de conversa natural.

Para empresas que criam chatbots orientados à ação, essa camada de integração geralmente representa o esforço de desenvolvimento mais substancial. Embora os componentes conversacionais se beneficiem dos avanços na IA de uso geral, essas integrações devem ser personalizadas para o cenário de sistemas específico de cada organização.

Considerações de segurança são particularmente importantes para chatbots com capacidade de ação. As melhores práticas incluem implementar autenticação adequada antes de operações sensíveis, manter registros de auditoria detalhados de todas as ações realizadas, fornecer etapas de confirmação claras para atividades consequentes e projetar um tratamento de falhas eficiente quando as integrações encontram problemas.

À medida que esses recursos de integração avançam, a fronteira entre interfaces conversacionais e aplicativos tradicionais continua a se confundir. As implementações mais sofisticadas hoje permitem que os usuários realizem tarefas complexas inteiramente por meio de conversas naturais, o que antes exigiria a navegação em várias telas em aplicativos tradicionais.

Treinamento e Melhoria Contínua

Diversas abordagens para treinamento e aprimoramento trabalham em conjunto:

Ajuste Fino do Modelo Fundamental: Os modelos de linguagem base que alimentam os chatbots podem ser ainda mais especializados por meio de treinamento adicional em dados específicos do domínio. Esse processo, chamado de ajuste fino, ajuda o modelo a adotar terminologia, padrões de raciocínio e conhecimento de domínio apropriados para aplicações específicas.

Aprendizado por Reforço a Partir do Feedback Humano (RLHF): Essa técnica utiliza avaliadores humanos para classificar as respostas do modelo, criando dados de preferência que treinam os modelos de recompensa. Esses modelos de recompensa, então, orientam o sistema para a geração de resultados mais úteis, precisos e seguros. O RLHF tem sido crucial na transformação de modelos de linguagem de geradores impressionantes, mas não confiáveis, em assistentes práticos.

Mineração de Conversas: Sistemas analíticos que processam registros de conversas anonimizados para identificar padrões, perguntas comuns, pontos de falha frequentes e caminhos de resolução bem-sucedidos. Esses insights impulsionam melhorias automatizadas e orientam refinamentos conduzidos por humanos.

Aprendizagem Ativa: Sistemas que identificam áreas de incerteza e sinalizam essas instâncias para revisão humana, concentrando o esforço humano nas oportunidades de melhoria mais valiosas.

Testes A/B: Estruturas experimentais que comparam diferentes estratégias de resposta com usuários reais para determinar quais abordagens são mais eficazes para vários cenários.

Para chatbots corporativos, o processo de treinamento normalmente começa com dados históricos – transcrições anteriores de atendimento ao cliente, documentação e informações sobre o produto. Esse treinamento inicial é então complementado com conversas de exemplo cuidadosamente elaboradas que demonstram o tratamento ideal de cenários comuns.

Uma vez implantados, os sistemas eficazes incluem mecanismos de feedback que permitem aos usuários indicar se as respostas foram úteis. Esse feedback, combinado com sinais implícitos como abandono de conversa ou perguntas repetidas, cria um rico conjunto de dados para melhoria contínua.

O papel humano no treinamento de chatbots modernos continua essencial. Designers de conversação elaboram os principais padrões de personalidade e comunicação. Especialistas no assunto revisam e corrigem as respostas propostas para garantir a precisão técnica. Cientistas de dados analisam métricas de desempenho para identificar oportunidades de melhoria. As implementações mais bem-sucedidas tratam o desenvolvimento de chatbots como uma parceria colaborativa entre humanos e IA, em vez de um processo totalmente automatizado.

Para empresas que implementam chatbots, estabelecer uma estrutura clara de melhoria é fundamental. Isso inclui:

Ciclos regulares de avaliação de desempenho

Equipe dedicada para monitoramento e aprimoramento

Métricas claras de sucesso

Processos para incorporar o feedback do usuário

Governança para gerenciar a qualidade dos dados de treinamento

Embora as abordagens específicas variem entre plataformas e aplicativos, o princípio fundamental permanece consistente: os chatbots modernos são sistemas dinâmicos que se aprimoram por meio do uso, feedback e aprimoramento deliberado, em vez de programas estáticos presos às suas capacidades iniciais.

Salvaguardas e Considerações Éticas

Essas salvaguardas normalmente incluem:

Filtragem de Conteúdo: Sistemas que detectam e previnem conteúdo prejudicial, ofensivo ou inapropriado tanto nas entradas do usuário quanto nas saídas do modelo. Implementações modernas utilizam modelos especializados, treinados especificamente para identificar conteúdo problemático em diversas categorias.

Aplicação do Escopo: Mecanismos que mantêm as conversas dentro de domínios apropriados, impedindo que os chatbots sejam manipulados para fornecer conselhos ou informações fora de sua finalidade e especialização pretendidas.

Controles de Privacidade de Dados: Proteções para informações sensíveis do usuário, incluindo princípios de minimização de dados, técnicas de anonimização e mecanismos de consentimento explícito para armazenamento ou uso de dados.

Mitigação de Viés: Processos que identificam e reduzem vieses injustos em dados de treinamento e saídas do modelo, garantindo tratamento equitativo entre diferentes grupos de usuários.

Verificação de Referências Externas: Para alegações factuais, particularmente em domínios sensíveis, sistemas que verificam as informações em relação a fontes externas confiáveis antes de apresentá-las aos usuários.

Supervisão Humana: Para aplicações críticas, revisar mecanismos que permitam o monitoramento e a intervenção humana quando necessário, particularmente para decisões consequentes ou tópicos sensíveis.

A implementação dessas salvaguardas envolve componentes técnicos e de políticas. No nível técnico, vários modelos de filtragem, algoritmos de detecção e sistemas de monitoramento trabalham em conjunto para identificar interações problemáticas. No nível de políticas, diretrizes claras definem casos de uso apropriados, isenções de responsabilidade necessárias e caminhos de escalonamento.

Os chatbots de saúde fornecem um exemplo claro desses princípios em ação. Sistemas bem projetados neste domínio normalmente incluem isenções de responsabilidade explícitas sobre suas limitações, evitam linguagem diagnóstica, a menos que seja validada clinicamente, mantêm controles rígidos de privacidade para informações de saúde e incluem caminhos de escalonamento claros para profissionais médicos humanos em caso de preocupações apropriadas.

Para empresas que implementam chatbots, surgiram diversas práticas recomendadas:

Começar com diretrizes éticas claras e limites de casos de uso;

Implementar múltiplas camadas de mecanismos de segurança em vez de depender de uma única abordagem;

Testes extensivos com diversos grupos de usuários e cenários;

Estabelecer protocolos de monitoramento e resposta a incidentes;

Fornecer informações transparentes aos usuários sobre as capacidades e limitações do sistema;

À medida que a IA conversacional se torna mais poderosa, a importância dessas salvaguardas só aumenta. As implementações mais bem-sucedidas equilibram inovação com responsabilidade, garantindo que os chatbots continuem sendo ferramentas úteis que aprimoram as capacidades humanas, em vez de criar novos riscos ou danos.

O futuro da tecnologia de chatbot

Capacidades Multimodais: A próxima geração de chatbots irá além do texto para incorporar perfeitamente imagens, voz, vídeo e elementos interativos. Os usuários poderão mostrar problemas por meio de suas câmeras, ouvir explicações com recursos visuais e interagir por meio de qualquer meio que seja mais conveniente para seu contexto atual.

Comportamentos Agenticos: Chatbots avançados estão migrando de respostas reativas a perguntas para a resolução proativa de problemas. Esses sistemas "agenticos" podem tomar iniciativa, dividir tarefas complexas em etapas, usar ferramentas para coletar informações e persistir até que os objetivos sejam alcançados – mais como assistentes virtuais do que simples chatbots.

Memória e Personalização: Os sistemas futuros manterão uma memória de longo prazo mais sofisticada das preferências do usuário, interações anteriores e histórico de relacionamento. Essa compreensão persistente permitirá experiências cada vez mais personalizadas, que se adaptam aos estilos de comunicação, níveis de conhecimento e necessidades individuais.

Especialistas em Domínios Especializados: Embora os chatbots de uso geral continuem a melhorar, também estamos presenciando o surgimento de sistemas altamente especializados com profundo conhecimento em domínios específicos – assistentes jurídicos com amplo conhecimento de jurisprudência, sistemas médicos treinados em literatura clínica ou consultores financeiros versados em códigos e regulamentações tributárias.

Inteligência Colaborativa: A linha entre as responsabilidades humanas e de IA continuará a se confundir, com modelos de colaboração mais sofisticados, nos quais chatbots e especialistas humanos trabalham juntos de forma integrada, cada um lidando com os aspectos da interação com o cliente em que se destacam.

Inteligência Emocional: Avanços no reconhecimento de afetos e na geração de respostas emocionais apropriadas criarão interações mais empáticas naturalmente. Os sistemas futuros reconhecerão melhor os sinais emocionais sutis e responderão com a sensibilidade adequada às necessidades do usuário.

Processamento Federado e no Dispositivo: Preocupações com a privacidade estão impulsionando o desenvolvimento de arquiteturas em que mais processamento ocorre localmente nos dispositivos dos usuários, com menos dados transmitidos para servidores centrais. Essa abordagem promete melhor proteção da privacidade, mantendo recursos sofisticados.

Esses avanços permitirão novas aplicações em todos os setores. Na área da saúde, os chatbots podem servir como acompanhantes contínuos da saúde, monitorando as condições e coordenando o atendimento entre os provedores. Na educação, eles podem atuar como tutores personalizados, adaptando-se aos estilos de aprendizagem e ao progresso individuais. Em serviços profissionais, podem se tornar assistentes de pesquisa especializados que ampliam drasticamente a expertise humana.

No entanto, essas capacidades também trarão novos desafios. Sistemas mais potentes exigirão mecanismos de segurança mais sofisticados. Interações cada vez mais semelhantes às humanas levantarão novas questões sobre a divulgação adequada da identidade da IA. E, à medida que esses sistemas se tornam mais integrados à vida cotidiana, garantir o acesso equitativo e prevenir dependências prejudiciais se tornarão considerações sociais importantes.

O que parece claro é que a linha entre chatbots e outras interfaces de software continuará a se confundir. A linguagem natural é simplesmente a interface mais intuitiva para muitas necessidades humanas e, à medida que a IA conversacional se torna mais capaz, ela se tornará cada vez mais a forma padrão de interagirmos com sistemas digitais. O futuro não se trata apenas de chatbots melhores – trata-se de a conversa se tornar a principal interface humano-computador para muitas aplicações.

Conclusão: A Conversa Contínua

Os chatbots modernos representam uma das aplicações mais visíveis e impactantes da inteligência artificial na vida cotidiana. Por trás de suas interfaces de bate-papo aparentemente simples, encontra-se uma orquestra sofisticada de tecnologias trabalhando em conjunto: modelos de base que fornecem compreensão da linguagem, sistemas de recuperação que fundamentam respostas em informações precisas, gerenciamento de estado que mantém conversas coerentes, camadas de integração que se conectam a sistemas de negócios e mecanismos de segurança que garantem o comportamento apropriado.

Essa arquitetura complexa possibilita experiências que pareceriam ficção científica há apenas uma década – conversas naturais com sistemas digitais que podem responder a perguntas, resolver problemas e executar ações em nosso nome. E, no entanto, ainda estamos nos estágios iniciais do desenvolvimento dessa tecnologia. Os recursos e aplicações da IA conversacional continuarão se expandindo rapidamente nos próximos anos.

Para empresas e organizações que buscam implementar a tecnologia de chatbots, compreender esses componentes subjacentes é crucial para definir expectativas realistas, fazer escolhas de design informadas e criar experiências de usuário verdadeiramente valiosas. As implementações mais bem-sucedidas não tratam os chatbots como caixas-pretas mágicas, mas sim como ferramentas sofisticadas cujas capacidades e limitações devem ser gerenciadas cuidadosamente.

Para os usuários que interagem com esses sistemas, uma espiada nos bastidores pode ajudar a desmistificar o que às vezes parece mágica tecnológica. Compreender os princípios básicos de como os chatbots modernos funcionam permite uma interação mais eficaz – sabendo quando eles podem ajudar, quando podem ter dificuldades e como se comunicar com eles com mais sucesso.

O que talvez seja mais notável sobre a tecnologia de chatbots é a rapidez com que nossas expectativas se adaptam. Recursos que nos surpreenderiam há alguns anos rapidamente se tornam a base que tomamos como certa. Essa rápida normalização demonstra como a conversa funciona naturalmente como uma interface – quando bem feita, ela simplesmente desaparece, deixando-nos focados em resolver problemas e realizar tarefas, em vez de pensar na tecnologia em si.

À medida que esses sistemas continuam evoluindo, a conversa entre humanos e máquinas se tornará cada vez mais fluida e produtiva – não substituindo a conexão humana, mas ampliando nossas capacidades e nos libertando para focar nos aspectos exclusivamente humanos do nosso trabalho e da nossa vida.